El auge de la Inteligencia Artificial (IA) generó que investigadores de todo el mundo intensificaran el uso de esta tecnología en diferentes proyectos, como por ejemplo para "leer" los pensamientos de una persona de forma no invasiva a través de un sistema de decodificación.

Este método fue utilizado a mediados de este año por un equipo de la Universidad de Texas en Austin, Estados Unidos, que se sirvió únicamente datos de resonancia magnética funcional para reconstruir pensamientos.

Mientras que los sistemas de decodificación de lenguaje anteriores requerían implantes quirúrgicos, el último avance plantea la posibilidad de nuevas formas de restaurar el habla en pacientes que luchan por comunicarse debido a un derrame cerebral o una enfermedad de la neurona motora.

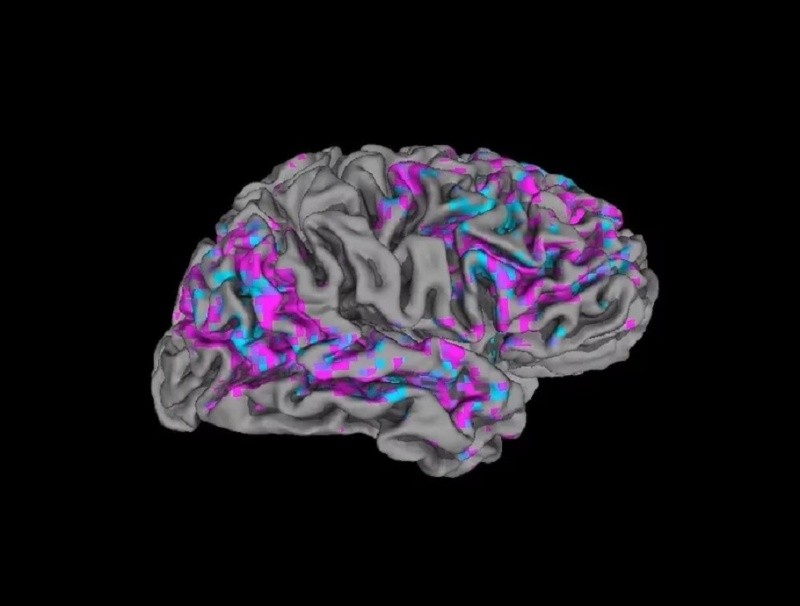

Alexander Huth, neurocientífico que dirigió el trabajo en la Universidad de Texas, explicó que esta técnica puede mapear la actividad cerebral en una ubicación específica con una resolución increíblemente alta. Sin embargo, existe un retraso de tiempo inherente, lo que hace imposible el seguimiento de la actividad en tiempo real.

El retraso existe porque las exploraciones por resonancia magnética funcional miden la respuesta del flujo sanguíneo a la actividad cerebral, que alcanza su punto máximo y regresa al valor inicial en aproximadamente 10 segundos, lo que significa que ni siquiera el escáner más potente puede mejorar esto. Se trata de un "indicador ruidoso y lento de la actividad neuronal", dijo Huth.

Este límite estricto ha obstaculizado la capacidad de interpretar la actividad cerebral en respuesta al habla natural porque proporciona una "mezcolanza de información" distribuida en unos pocos segundos.

Sin embargo, el desarrollo de los modelos grandes de lenguaje (el tipo de IA con el que funcionan aplicaciones como ChatGPT) permite una forma alternativa de llevar a cabo este trabajo. "He estado trabajando en esto durante 15 años... así que fue impactante y emocionante cuando finalmente funcionó", expresó Huth.

Estos modelos son capaces de representar, en números, el significado semántico del habla, lo que permite a los científicos observar qué patrones de actividad neuronal se corresponden con cadenas de palabras con un significado particular en lugar de intentar leer la actividad palabra por palabra.

Escaneos y modelos de lenguaje

Para que los investigadores pudieran probar la efectividad de esta técnica, tres voluntarios permanecieron recostados en un escáner durante 16 horas cada uno mientras escuchaban podcasts. En tanto, el decodificador fue entrenado para hacer coincidir la actividad cerebral con su significado utilizando el modelo de lenguaje GPT-1, un precursor de ChatGPT. El paso siguiente fue escanear nuevamente la actividad cerebral de los participantes, pero esta vez mientras escuchaban una nueva historia y simplemente la imaginaban. Los resultados mostraron que, alrededor de la mitad de las veces, el texto coincidía estrechamente (y a veces con precisión) con los significados previstos de las palabras originales. "Nuestro sistema funciona a nivel de ideas, semántica y significado", afirmó Huth, que precisó: "Esta es la razón por la que lo que decimos no son las palabras exactas, sino la esencia". Por ejemplo, cuando a un participante se le reprodujeron las palabras "Aún no tengo mi licencia de conducir", el sistema decodificó lo siguiente: "Ni siquiera ha empezado a aprender a conducir todavía". También se pidió a los participantes que miraran cuatro videos cortos y silenciosos mientras estaban en el escáner, y el decodificador pudo usar su actividad cerebral para describir con precisión parte del contenido, dice un artículo publicado en Nature Neuroscience. "Para un método no invasivo, este es un verdadero avance en comparación con lo que se ha hecho antes, que normalmente consiste en palabras sueltas u oraciones cortas", dijo Huth. En cuanto a las fallas, se identificó que el decodificador tenía problemas con ciertos aspectos del lenguaje, incluidos los pronombres. "No sabe si es en primera o tercera persona, si es hombre o mujer", dijo Huth. El profesor Tim Behrens, neurocientífico computacional de la Universidad de Oxford que no participó en el trabajo, lo describió como "técnicamente extremadamente impresionante" y dijo que abrió una serie de posibilidades experimentales, incluida la lectura de pensamientos de alguien que sueña o la investigación de cómo funcionan las nuevas ideas. "Estos modelos generativos te permiten ver lo que hay en el cerebro a un nuevo nivel", destacó. Shinji Nishimoto, de la Universidad de Osaka y pionero en la reconstrucción de imágenes visuales a partir de la actividad cerebral, manifestó: "El artículo demostró que el cerebro representa información lingüística continua durante la percepción y la imaginación de manera compatible. Este es un hallazgo no trivial y puede ser una base para el desarrollo de interfaces cerebro-computadora".