“¿Nos metieron en una full estafita o me parece a mi?”, preguntó Migue Granados en X, comentando una publicación de un usuario en la que se compartía un fragmento de su entrevista cara a cara con Lionel Messi, grabada en septiembre del año pasado. En el clip, Granados le consulta a La Pulga cuales son sus fuentes de ingresos, a lo que Leo responde que como futbolista tiene contratos publicitarios con diferentes marcas, pero que el mes pasado lanzó “él y su equipo lanzaron una aplicación móvil con la que cualquiera puede ganar 800 mil pesos al día” y que, por extraño que parezca, se ha transformado en “su principal entrada de dinero”.

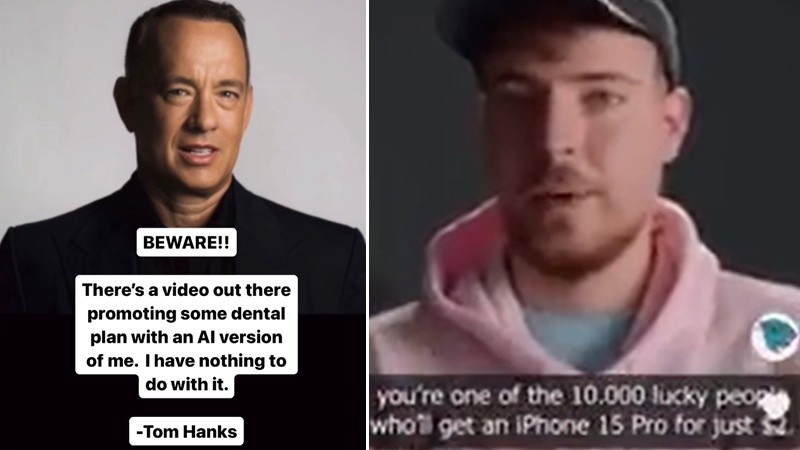

Como era de esperarse a partir de una declaración tan insólita, el video en cuestión resultó ser en realidad un deepfake, una sofisticada estafa que utiliza inteligencia artificial para manipular imágenes y audios de manera hiperrealista con el fin de engañar a las personas. En este caso, las supuestas afirmaciones de Messi sobre su lucrativa aplicación móvil eran completamente falsas, creadas mediante inteligencia artificial para promover una app de apuestas online aprovechando la fama planetaria del astro argentino. Si bien en este caso la voz de Leo es fácilmente reconocible como una manipulación fraudulenta, eso no quita que los deepfakes sean una amenaza en expansión que hay que tomar muy en serio.

Nos metieron en una full estafita o me parece a mi? https://t.co/RieySJ4K2U

— Migue Granados (@miguegranados) March 16, 2024

Una personalidad que suele ser blanco central en intentos de estafa a partir de deepfakes es el empresario y visionario Elon Musk, CEO de Tesla y SpaceX. En más de una ocasión han aparecido vídeos falsos del magnate sudafricano promoviendo supuestas inversiones en criptomonedas, tanto en Facebook, YouTube, como en anuncios pagos en Google y otras plataformas. Incluso, puede encontrarse ocasionalmente este tipo de contenidos como publicidad engañosa en X, la red social propiedad de Musk. Al igual que el falso video de Messi, este tipo de grabaciones manipuladas utilizan imágenes auténticas, pero dobladas con una voz generada artificialmente que imita características propias del hablante original, como el acento, el timbre, el tono y la cadencia.

El proceso para generar una voz sintética que simule fielmente a una persona consiste en alimentar un modelo de inteligencia artificial con numerosas muestras de audio de la voz objetivo. Mediante técnicas avanzadas de aprendizaje automático y procesamiento del lenguaje natural, el sistema analiza minuciosamente los patrones vocales únicos del individuo. Luego, utilizando los datos extraídos de esas grabaciones, la IA es capaz de renderizar y sintetizar un nuevo audio que replica de manera hiperrealista la voz auténtica del dueño de la voz suplantada, produciendo una imitación prácticamente indistinguible para el oído humano. Con la tecnología disponible actualmente, basta con apenas unos fragmentos cortos de audio para entrenar un modelo de IA que pueda reproducir cualquier texto en la voz original.

El software necesario para generar deepfakes se puede obtener de manera gratuita y es fácil de descargar, aunque eso no implica que sea una tarea sencilla. El procedimiento para lograr resultados verosímiles no solo demanda hardware potente, sino que también se requiere dominar una amplia gama de conocimientos técnicos avanzados, que van desde el funcionamiento de redes neuronales hasta la edición y postproducción de audio y video. No hace falta ser un académico ni tener formación profesional en estas disciplinas, solo se necesita una férrea voluntad de aprender de manera autodidacta. La información y recursos están disponibles libremente en internet, pero adquirir las habilidades para aplicarlos de manera experta demandan trabajo y dedicación.

Los delincuentes no solo buscan engañar a sus víctimas utilizando deepfakes de voces y videos de celebridades. El año pasado, en un lapso de apenas tres días, entre el 28 de febrero y el 2 de marzo, al menos ocho adultos mayores de San Juan de Terranova, Canadá, fueron víctimas de un elaborado fraude en el que los criminales emplearon inteligencia artificial para clonar las voces de sus propios nietos y extorsionarlos. En total, los ancianos perdieron más de 200.000 dólares al ser engañados por los audios generados a partir de grabaciones reales de sus familiares, obtenidas presumiblemente de videos publicados en TikTok y otras plataformas.

En otro incidente el pasado mes de febrero, un empleado de una multinacional fue víctima de un sofisticado fraude al ser engañado para participar en una videoconferencia con los que creía que eran varios miembros del personal de la empresa. Sin embargo, todos ellos eran deepfakes, incluído el estafador que se hizo pasar por el director financiero de la compañía, quien le solicitó al empleado que realice una transferencia por más de 25 millones de dólares. El trabajador nunca sospechó nada, ya que los participantes de la reunión se veían y sonaban como colegas reconocibles.

Estos casos son apenas la punta del iceberg, evidencia de la ingeniosa capacidad de los ciberdelincuentes para personalizar y hacer más convincentes sus estafas mediante el uso malicioso de tecnologías de vanguardia. La explotación de estas herramientas avanzadas para engañar y cometer fraudes económicos está generando una preocupación cada vez mayor entre las autoridades de todo el mundo. Ya no se trata solo de imitar voces o rostros famosos, sino ahora pueden recrear con escalofriante realismo la apariencia física y la dicción de familiares, amigos o conocidos para suplantar sus identidades y despojarlos de sus bienes y dinero.

Si bien esta tecnología tiene aplicaciones legítimas, su uso con fines delictivos está obligando al derecho a establecer nuevas regulaciones contra quienes explotan estos avances para cometer estafas financieras y otros ilícitos. Por ejemplo, en Estados Unidos se han presentado proyectos de ley para prohibir la creación y difusión de deepfakes con intenciones defraudatorias. Mientras tanto, la Unión Europea también está desarrollando un marco legal estricto para regular el uso malintencionado de esta tecnología, como la reciente Ley de Inteligencia Artificial aprobada el pasado miércoles 18 de marzo por el Parlamento Europeo, aunque algunos expertos consideran que dicha legislación no aborda adecuadamente la amenaza creciente que representan los deepfakes.

“En nuestro país, el delito de estafa está tipificado en el artículo 172 del Código Penal, y requiere de dos elementos clave, el ardid o engaño y el perjuicio patrimonial a la víctima”, explica Gonzalo Jeangeorges, abogado especialista en derecho informático. En este caso, “el ardid consiste en suplantar la identidad de una persona real utilizando un deepfake, es hacerse pasar por otro para defraudar a un tercero”, explica el letrado. Si bien cuando se redactó el Código Penal esta tecnología no existía, “la creación y utilización de deepfakes con fines defraudatorios, como inducir a una persona a realizar transacciones financieras creyendo que interactúa con otra, configuraría una estafa penada por el artículo 17. al hacerse pasar por otro para defraudar”.

“La identificación de un deepfake está en los detalles”, indica Fernando Villares, ingeniero en sistemas, especialista en Inteligencia Artificial y seguridad informática. “Muchas veces, la sincronía entre la voz del deepfake y el movimiento de los labios se pierde, porque el sistema no tiene ajustado la concordancia de todo lo que no se ve, como los movimientos de la lengua, el paladar y la posición de los dientes”, explica. “También hay que prestar especial atención a la tersura de la piel de la cara y del cuello. Ir al mínimo detalle, que son los poros. Si los poros no se mueven naturalmente acompañando el movimiento de la persona, ya tenés que empezar a sospechar”.

Según precisa Villares, también hay que reparar escrupulosamente en las particularidades de los movimientos involuntarios que se producen de forma natural, como el parpadeo de los ojos y la dinámica de cejas y cabello, ya que estos fluyen de manera sutil e individual. "Si los elementos del rostro de una persona se perciben excesivamente estáticos, es otro indicio revelador de que estamos frente a un deepfake, al igual que difuminados o blur en los movimientos de los músculos que rodean la boca, o una tasa excesivamente baja o alta de parpadeos ", advierte el experto. “El iris también suele ser revelador, ya que los renderizados en este caso no captan todos los detalles”, agrega. Otro factor a considerar es la composición general de luces, sombras y texturas sobre la piel, que suele carecer del realismo y las imperfecciones propias de los rasgos humanos.

Si bien estas pequeñas imperfecciones pueden pasar desapercibidas para el ojo casual, los expertos están entrenados para detectar estas sutiles inconsistencias que delatan la naturaleza artificial del contenido audiovisual. No obstante, a medida que la tecnología de deepfakes avanza, estos detalles se vuelven cada vez más difíciles de identificar.

Sin embargo, existen otros elementos reveladores imposibles de sintetizar, al menos con la tecnología actual. Villares, experto en informática forense, ha elaborado un modelo matemático basado en la psicología, y según explica, “las personas tienen lapsus, cometen errores de una forma aleatoria o de una manera específica según la psiquis de cada individuo. Cuando generas un deepfake, esa persona sintética no comete los mismos errores ni tiene la misma tasa de actos fallidos que una persona real. Si analizamos el comportamiento psicológico del individuo en la vida real y lo comparamos con el deepfake, vamos a encontrar incoherencias”.

En los últimos meses se ha desarrollado software con técnicas prometedoras que analizan patrones estadísticos complejos en los píxeles de las imágenes o en las firmas espectrales del audio para detectar si han sido manipulados o generados artificialmente. “Para el común de la gente, por una cuestión de costos, es prácticamente imposible obtener estas herramientas, son productos de nicho con un precio prohibitivo. Si querés hacerlo, tenés que hacerlo de forma manual, digamos”, señala el especialista.

A medida que surjan nuevas técnicas para generar este tipo de contenido sintético, más difícil se volverá su identificación mediante la simple observación, llegando a un punto donde se volverá imposible determinar si lo que estamos viendo es verdadero o falso. Los deepfakes plantean un juego del gato y el ratón entre la tecnología y las herramientas para detectarlos, amenazando con romper los límites entre la realidad y la ficción, y con ello, nuestras nociones fundamentales de verdad y confianza. Una amenaza a la integridad de todo lo que conocemos: las instituciones democráticas, los procesos judiciales, los intercambios comerciales y hasta nuestras relaciones interpersonales. Es una carrera tecnológica que no podemos permitirnos perder, porque cuando dudemos de todo lo que vemos y escuchamos, será simplemente el fin.