Google reveló los detalles y características de funcionamiento de su apuesta más grande en materia de Inteligencia Artificial (IA) hasta la fecha: Gemini, un "nuevo modelo multimodal" que podría desplazar del centro de la escena al ya famoso ChatGPT de OpenAI, que tras su lanzamiento a finales del 2022 desató una carrera entre las grandes compañías tecnológicas por dominar el terreno de los modelos grandes de lenguaje (LLM, por sus siglas en inglés).

La demostración de lo que es capaz de hacer Gemini, que tuvo lugar este miércoles a partir de una serie de videos difundidos por Google, representa el paso más importante que ha dado la compañía para exponer los avances de un trabajo de desarrollo que lleva años y se intensificó durante los últimos meses. En mayo pasado, durante su conferencia para desarrolladores llamada I/O, la empresa había anunciado que en poco tiempo lanzarían este nuevo modelo.

La ventaja central que le permite a Gemini sobresalir entre otros modelos de la competencia es su multimodalidad, es decir, su capacidad para comprender no solo texto sino además otro tipo de formatos como imágenes, video, audio e incluso código de programación, interactuando y procesando toda la información en simultáneo. Otras empresas, como OpenAI, han desarrollado modelos diferenciados como DALL-E –para la generación de imágenes– y Whisper –reconocimiento de voz–.

Esta característica del nuevo modelo de Google es la conjunción de todo el tiempo y los recursos que la empresa ha dedicado a la investigación en el campo de la IA, en donde hicieron aportes fundamentales para que se configurara el escenario actual.

Sundar Pichai, CEO de Google, dijo que este lanzamiento representa una nueva era para la IA dentro de Google. "Una de las cosas más poderosas de este momento es que puedes trabajar en una tecnología subyacente, mejorarla y que inmediatamente fluya a través de nuestros productos", destacó.

Cómo es Gemini, la nueva IA de Google

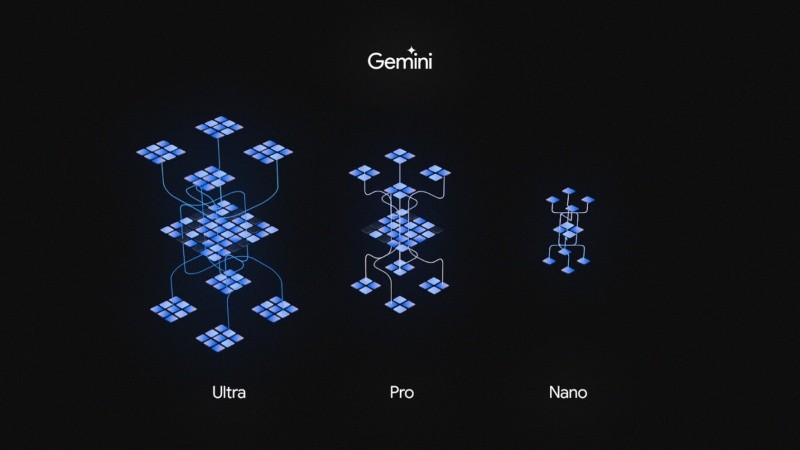

En uno de los videos que fueron publicados por la empresa y compartido por Pichai, se puede ver a Gemini en funcionamiento. "Dime lo que ves", es la petición mediante voz que da inicio a la interacción con el modelo, que comienza a identificar y describir lo que colocan frente a una cámara con la que está conectado. Al ver los trazoz de algunas líneas sobre un papel, Gemini solo describe detalles superficiales, pero a medida que el dibujo va tomando forma el modelo identifica particularidades de lo que primero describe como "un pájaro" y, luego, como "un pato". La IA sigue todo el proceso en tiempo real y no solo interpreta lo que muestra la imagen para hacer una mera descripción, sino que además agrega datos adicionales y continúa respondiendo al diálogo con la persona con la que interactúa. Gemini también es capaz de hacer traducciones a otros idiomas, como español, francés y japonés; y reproducir un audio con la pronunciación correcta de cada palabra, al igual que el traductor de Google. No obstante, para interactuar de momento solo se puede hacer en inglés. El video también da cuenta de la complejidad que alcanza la interacción entre el humano y el modelo. "Basándote en lo que vez, propón una idea de juego, y usa emojis", se le pide a Gemini, que al identificar el mapamundi que se le está mostrando sugiere jugar a adivinar el país, para lo cual genera pistas que representa con emojis. En otro de los momentos del video, la IA es capaz de reconocer el dibujo final en uno de los clásicos juegos de unir puntos para completar la imagen, que al principio parece ser el de un gato. El modelo no solo interpreta que se trata del conocido juego, sino que además es capaz de completar el boceto correctamente. Mientras que los modelos más básicos de Gemini admiten entrada y salida de texto, los más potentes pueden funcionar con imágenes, video y audio. "Y se volverá aún más general", afirmó Demis Hassabis, director ejecutivo de Google DeepMind, la división de la compañía dedicada a investigaciones sobre IA y Machine Learning. Hassabis anticipó que con el tiempo se sumarán otras vías de interacción "como la acción y el tacto" para mejorar aún más el modelo. Gemini tendrá más sentidos, se volverá más consciente y será más preciso, lo que le permitirá también superar los sesgos y alucinaciones que generan problemas en sus resultados, agregó el encargado de DeepMind. Gemini cuenta con tres versiones diferentes: Gemini Nano, que es más acotada y podrá funcionar de manera nativa y offline en dispositivos Android; Gemini Pro, que potenciará los servicios de IA de Google, incluido su chatbot Bard; y Gemini Ultra, el LLM más poderoso de los tres que se lanzará el próximo año y está pensado para la ejecución de tareas en centros de datos y usos corporativos. Hassabis y Pichai comentaron que Google no pretende avanzar lo más rápido posible en el desarrollo de estos modelos, sino más bien hacerlo de forma responsable. Su propósito final, como ya han anticipado, es conseguir una Inteligencia Artificial General (AGI), cuyas capacidades superarán a las de los humanos y le permitirán mejorarse a sí misma. "A medida que nos acerquemos a AGI, las cosas serán diferentes", afirmó Hassabis, y sumó: "Es una especie de tecnología activa, por lo que creo que debemos abordarla con cautela. Con cautela, pero con optimismo".Tres versiones y llegada al motor de búsqueda