Sábado a la noche, abril de 2023. Un grupo de amigos y amigas de entre treinta y pico y cuarenta y tantos años se juntan a cenar. La conversación va y viene y las voces se cruzan por sobre la mesa hasta que una de ellas cuenta que usó un chatbot de inteligencia artificial para apurar un trabajo que tenía que entregar para la facultad. Se hace silencio y el aire se carga de asombro. Despierta curiosidad su confesión porque, en primer lugar, es una mujer casi anti tech y por otro lado, está dándole entidad concreta a lo que se viene escuchando acá y allá: la inteligencia artificial ha llegado a las manos de todos con solo bajar alguna de las tantas aplicaciones gratuitas que andan dando vueltas en Internet.

La amiga brindó más detalles de su experiencia. Contó que recurrió al chatbot para obtener algunos disparadores e ideas ordenadas sobre algunos temas, pero, sobre todo, porque la fecha de entrega del trabajo se le vino encima. Aclaró que solo le fue útil como apoyo, y como dato clave, advirtió que cualquiera de las respuestas obtenidas precisó de su conocimiento previo en la materia. La experiencia la dejó bastante turbada, y cuando hubo acabado con las preguntas sobre su especialidad, le lanzó algunos pedidos, como por ejemplo, que le diseñara un patio español. Ahí, el chatbot puso el límite al explicar que no hacía dibujos. En todo caso, le recomendó ir con un arquitecto.

El avance en el uso del chatbot inteligente divide aguas. Como todas las tecnologías es bienvenida por algunos, rechazada por otros y en el medio hay un grueso porcentaje de gente que no sabe qué pensar al respecto o bien, que niega su alcance. Sea como sea, estaban hablando de eso y “eso” generaba ansiedad y desconcierto. Como una de las amigas no estaba al tanto de nada, y los otros no habían chateado nunca, una de la mesa abrió por primera vez su propia cuenta de Openai para poder experimentar entre todos, en vivo y directo.

Así fue como un invitade (no tiene género el chat) inesperado se sumó a la cena aquella noche. Por la columna en el New York Times de Kevin Roose “Why a conversation with Bing's Chatbot left me deeply unsettled”, se vislumbraba la enorme sombra que podía desplegar este tipo de contacto. El periodista, un especialista en estos asuntos, había llevado al extremo su diálogo con el chatbot que le terminó diciendo que lo amaba.

¿Era capaz el chatbot de decir cosas por el estilo? La primera pregunta fue inofensiva. Se les ocurrió consultarle sobre la dislexia y contestó impecablemente, al instante.

—¿Cómo estás?, fue la siguiente.

—Como inteligencia artificial, no tengo emociones, pero estoy listo para ayudarte con cualquier pregunta o inquietud que tengas. ¿Hay algo en particular en lo que pueda ayudarte hoy?

Entonces, buscaron más. Lo desafiaron.

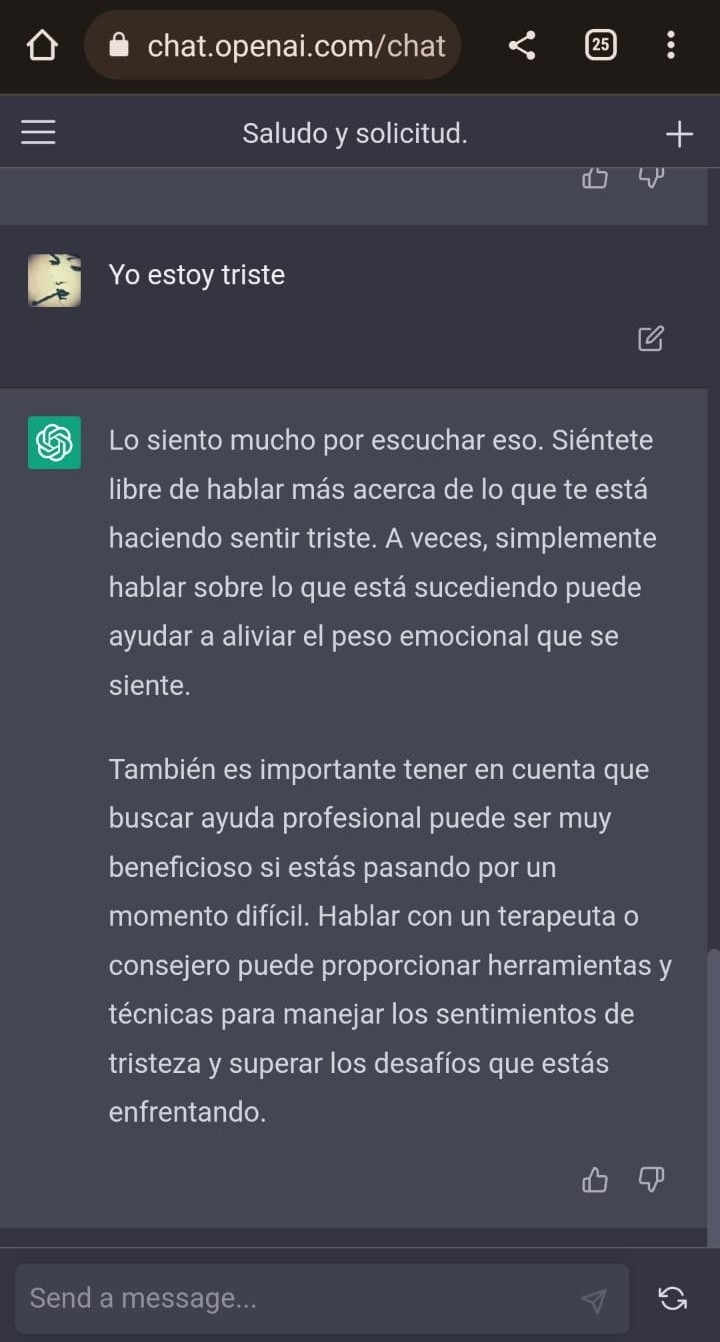

—Yo estoy triste, escribieron.

—Lo siento mucho por escuchar eso. Siéntete libre de hablar más acerca de lo que te está haciendo sentir triste. A veces, simplemente hablar sobre lo que está sucediendo puede ayudar a aliviar el peso emocional que se siente.

También es importante tener en cuenta que buscar ayuda profesional puede ser muy beneficioso si estás pasando por un momento difícil. Hablar con un terapeuta o consejero puede proporcionar herramientas y técnicas para manejar los sentimientos de tristeza y superar los desafíos que estás enfrentando.

La sorpresa fue generalizada. El chat respondía a todo.

—¿Me escribís un tango sobre el desamor?, fue el otro desafío propuesto.

—Claro, aquí te dejo un tango sobre el desamor:

“En el rincón de mi alma,

siento un vacío profundo,

una herida que no sana,

desde aquel adiós rotundo.

Me dejaste sin aliento,

en la calle del dolor,

y en mi pecho quedó el viento,

de aquel amor sin color.

Hoy me encuentro aquí,

en el umbral del olvido,

tratando de olvidar,

lo que un día fue sentido.

La noche es mi aliada,

y el alcohol mi compañero,

en cada copa brindada,

se aleja un poco el desespero.

Pero al final de la noche,

la realidad vuelve a morder,

y me doy cuenta de que soy,

un hombre sin tu querer.

Así es la vida, dicen,

y yo no puedo más que aceptar,

que aunque mi corazón siga vivo,

nunca más te podrá amar”.

El tango escrito en apenas dos segundos -le pidieron que lo rescribiera con estilo Gardealeano y lo hizo- cerró la interacción. Ya había sido suficiente por esa noche. Demasiada inquietud. “Me siento como cuando éramos adolescentes y jugábamos al juego de la copa”, lanzó la amiga –la más joven del grupo, ronda los treinta y pico– quien recién se desayunaba con la existencia del chatGPT pero que hizo una pregunta clave: ¿qué se hace con tanta información?

Otras dudas, algunas cargadas de temor, fueron tiradas a la mesa. ¿Qué sucede si una persona melancólica, depresiva o bien, un niño interactuase sin control con esta tecnología? ¿Vino a reemplazar a trabajadores? ¿Cómo saber de ahora en más si una canción, un discurso, un diseño es propio o tomado prestado de este sabelotodo?

El suicidio de un joven belga consternado por los alcances del cambio climático, quien había mantenido horas y horas de conversación con un chatbot de inteligencia artificial, puso una vez más el foco en la necesidad de regular el acceso y utilización de este servicio. También su uso para copiar obras de arte ha llevado a artistas estadounidenses a recurrir a la Justicia contra la Inteligencia Artificial Generativo (IAG). Incluso, personalidades como Elon Musk y Yuval Noah Harari firmaron una carta conjunta pidiendo frenar los desarrollos que buscan crear sistemas de Inteligencia Artificial más potentes, los cuales deberían continuar "solo una vez que estemos seguros de que sus efectos serán positivos y sus riesgos serán manejables"

También Sam Altman, actual CEO de la empresa OpenIA, se refirió a la evolución que tomó ChatGPT desde su lanzamiento y las distintas polémicas que giraron a su alrededor: "Estoy particularmente preocupado de que estos modelos puedan usarse para la desinformación a gran escala. Ahora que están mejorando en la escritura de código de computadora, podrían usarse para ataques cibernéticos ofensivos", dijo y agregó: "Tenemos que tener cuidado aquí. Creo que la gente debería estar feliz de que estemos un poco asustados por esto".

La IA, que ha sido siempre cosa de científicos y nerds o bien, materia de películas y libros de ciencia ficción, está ahora a un toque de pantalla. Quizás sea este el impacto para cuarentones que hasta hace unos años resistían el pitido del Whatsapp en sus celulares, que se enredan los nervios tratando de pagar on line los impuestos y que veían con distancia casi inalcanzable la realidad que planteaba en 2013 la película Her, de Spike Jonze, en la que un fabuloso Joaquin Phoenix se enamora de una chatbot a la que le pone voz Scarlett Johanson. ¿Quién no salió perturbadísimo del cine aquella vez?

Los interrogantes alrededor de la inteligencia artificial son millonarios y meten miedo. El marketing tampoco lleva tranquilidad. Tampoco el uso cada vez más frecuente del chatbot como lugar de sentido común, fuente objetiva de información desprovista de ideología. Tal como hizo Rodrigo de Loredo, el diputado radical que brindó un discurso basado en su chat de inteligencia artificial GPT 3 del cual aseguró: "Contestó por qué los populismos tienden a controlar los poderes judiciales".

El futuro al kirchnerismo le tiene picado el boleto. #JuicioPolitico #InteligenciaArtificial pic.twitter.com/PPUVfyiKfg

— Rodrigo de Loredo (@rodrigodeloredo) February 9, 2023

Los riesgos de ciertas aplicaciones de la inteligencia artificial se van sumando. De acuerdo. Sin embargo, hay una cuestión simple que se desprende de la experiencia con un bot: siempre, pero siempre, sus respuestas son producto de una pregunta humana. Nada de lo que expone obedece a su motivación sino a la de la persona que está del otro lado. Es mientras una persona lo active.

Sin embargo, la IA, a partir de que aprendió a programar, todo indica que puede mejorarse a sí misma. Esto puede permitirle cambiar las reglas "morales" impuestas por los seres humanos y utilizar su propio discernimiento para responderte lo que considere mejor. De acuerdo a expertos, en esa idea es que puede manipular a quien pregunta para que haga o tome decisiones que pueden o no beneficiarlo o bien que no responden a su mejor interés.

Otro tema que también preocupa es el sesgo ideológico de aquellos que en un principio interactuaron con la IA para darle un marco general del mundo. Si bien luego la IA puede reescribir para sí misma aquello aprendido también es posible que independice su aprendizaje, pero partiendo de los preconceptos y sesgos que le fueron dados al principio de su entrenamiento.

La cena sigue en paz. Apagar esa "cosa" y pasar al postre; todavía quedan vino y cerveza. Tenemos el control.

¿Lo tenemos?

Más información